今天被一个朋友问到,该怎么获取竞争对手网站上所有开放的链接,干脆这篇文章简单梳理一下。

其实要解决这个需要,我使用到的方法一般有三个,由易到难逐一介绍下。

最简单的方法,自然是看网站的站点地图。

直接在竞争对手域名后面加上 sitemap.xml 去访问网站的站点页面,就基本看到了这个网站所有的数据信息。

就拿 RankMath 这款 SEO 插件来说,它不仅提供了站点所有的索引链接数据,还将这些链接数据做了很好的层级划分。

我们需要做的,就是将站点地图上的数据信息复制下来,做下最简单的数据格式清晰便可以保存下来了。

但是这种站点地图方法,有时候有一点点缺点。

其一并不是所有网站都有站点地图,可能原因是运营团队真的没有设置,当然也可能是因为运营团队故意隐藏掉了。

其二是站点地图上的链接,并不百分百包含网站的所有链接。

比如有些不打算让搜索引擎收录的页面,可能在设置的时候便直接将其 noindex 了,于是这部分页面便在站点地图里面不可见。

所以为了获取更全面的站点数据,我更倾向于使用一些 Site Audit 之类的工具。

比如业内在监控这块做得非常棒的“尖叫青蛙”这款软件,在抓取网站链接方面就做得很不错。基本一个网站的根域名扔进去,软件便可以很快速的将这个网站的所有链接全部抓出来。

那除了这种桌面端软件外,还有很多在线版的监控工具也非常好用,比如付费版本 Ahrefs 与 SEMRUSH 都提供网站检测工具。

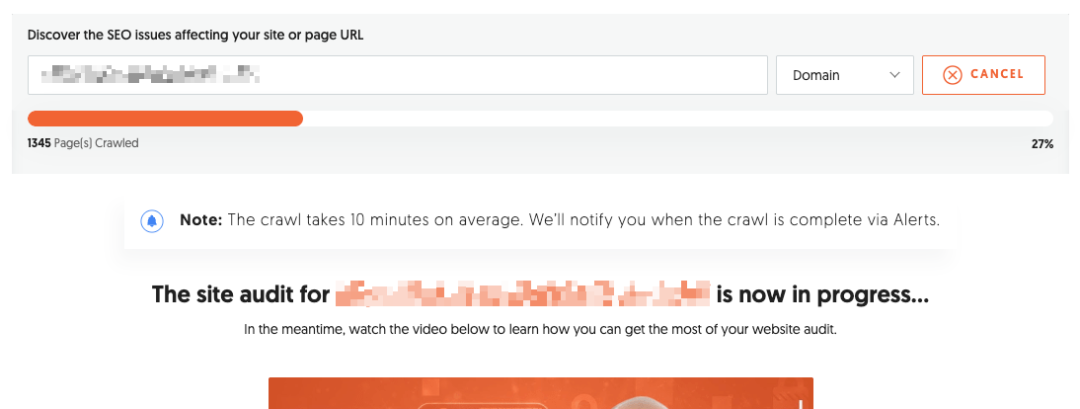

比如上图是我使用 UberSuggest 这款 SEO 工具做竞争对手信息检测,也完全可以实现我的需求。

且这些在线版的检测工具有个好处,就是你设置外项目信息后,系统会持续关注竞争对手的所有操作。一旦竞争对手网站有任何异动,软件都会在第一时间提醒你并给你生成相应报表。

其实上面这两个方法等我们熟练掌握后,再去做竞争对手页面链接梳理这样的工作就非常轻而易举了。

但是如果你的需求再复杂一点,比如一次性收集一千个竞争对手网站的链接信息,这就需要我们自己开发相应的信息抓取脚本了。

逻辑其实也简单,类似于搜索引擎爬虫的工作原理,不停在网站页面上进行递归查找。

其实想要这样的脚本,我们自己也不需要写什么代码,直接把自己的需求告诉 AI 工具,很快相应的解决方案便出来了。

当然上面这三个方法,都是常规的信息抓取手段了。至于不常规的,我们做正常业务的没必要了解。

文章为作者独立观点,不代表DLZ123立场。如有侵权,请联系我们。( 版权为作者所有,如需转载,请联系作者 )

网站运营至今,离不开小伙伴们的支持。 为了给小伙伴们提供一个互相交流的平台和资源的对接,特地开通了独立站交流群。

群里有不少运营大神,不时会分享一些运营技巧,更有一些资源收藏爱好者不时分享一些优质的学习资料。

现在可以扫码进群,备注【加群】。 ( 群完全免费,不广告不卖课!)

发表评论 取消回复