虽然理论上谷歌的爬虫会自动来爬取我们的网站内容,然后收录新的链接内容。但是这个过程真的非常耗时间,并不是每个人都能等得了。

像我平时做完新的内容链接后,都习惯手动将链接提交到站长工具后台请求收录。这么处理一下,原本可能需要几天才能处理完的过程,可能最终就只需要几个小时了,应该说是极大加快了收录的速度吧。

但不方便的便是,站长工具的手动提交方式是有提交额度限制的。像一个新账户,基本每天提交 10 条链接左右便会触发限制。至于其他的内容,就只能顺延到第二天了。

其实谷歌官方的收录策略主要有两个,其一就是上面提到的在站长工具中主动提交链接收录请求,其二是给新的内容做外链,当爬虫抓取到链接信息时便会主动去抓取然后收录。

但是这种做外链的方式,确实成本蛮高的,并不适合绝大多数站点。那如果我们采用灰黑手段的话(比如蜘蛛池),怎么尽可能去提交大量链接的收录请求呢?

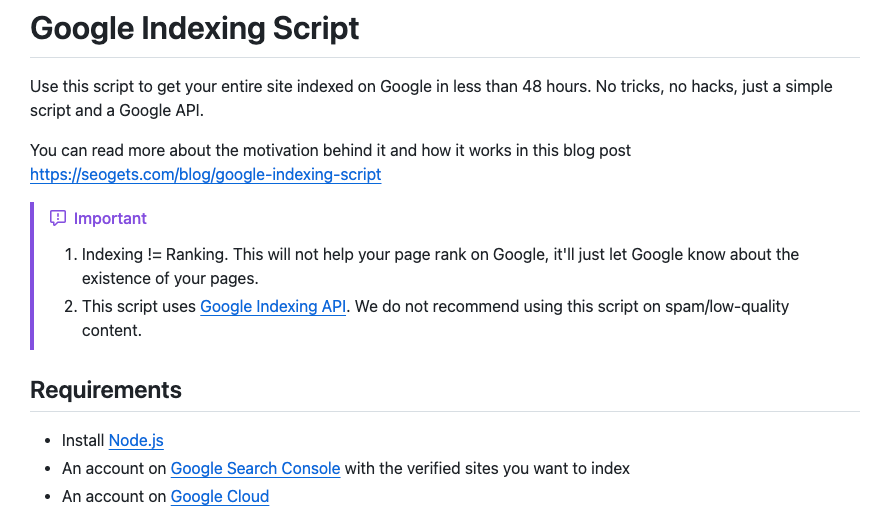

其实针对这个问题,谷歌官方是有相应的 API 支持。通过调研谷歌 API 的能力,然后直接将链接内容提交后,请求搜索引擎的收录。

像上面这种开源代码库,便是调用的 Google Cloud 的服务能力,来做内容链接的提交。至于具体的技术原理,便是利用上面提到的“方式二”。

所以如果你的网站每天都有很多很多内容需要提交收录,但是苦于找不到性价比比较高的方案,不妨试试这种“几乎免费”的链接提交方法。

文章为作者独立观点,不代表DLZ123立场。如有侵权,请联系我们。( 版权为作者所有,如需转载,请联系作者 )

网站运营至今,离不开小伙伴们的支持。 为了给小伙伴们提供一个互相交流的平台和资源的对接,特地开通了独立站交流群。

群里有不少运营大神,不时会分享一些运营技巧,更有一些资源收藏爱好者不时分享一些优质的学习资料。

现在可以扫码进群,备注【加群】。 ( 群完全免费,不广告不卖课!)

发表评论 取消回复