点击上方蓝字

惯例,先问大家几个问题:

你是不是发现,给 AI 喂资料,要么一篇一篇喂,要么一篇一篇粘到文档里再喂,费时费力?

你想要分析竞对的 blog 文章,数一数,是不是发现有几十,甚至几百篇?抓取内容是个大问题?

你想要分析竞对的 top pages 内容,是不是发现你只能一个个点链接进页面去看?

…

出现这些问题,是因为我们缺少高效抓取和整合内容的手段。

好消息,今天就给大家分享一个免费的自动化工具,可以一键抓取 url 内容并直接生成 PDF 文件。

你只需要花几分钟确定抓取内容,抓取和收集过程交给这个工具,拿到结果最后交给 AI 处理,非常省事。

另外,这个工具能够帮助 AI 写作更好地符合 EEAT 原则。

照顾到不懂的朋友,简单解释下什么是EEAT:

EEAT(Experience、Expertise、Authoritativeness、Trustworthiness),是谷歌评价网站内容质量的重要框架,而质量一直都是谷歌排名的核心环节之一。虽然不是 Google 算法中的直接排名因素,但这方面做得好谷歌会更信任你,对你的排名就更有利。

AI 写作很容易遇到杜撰和抽风问题,它的数据库里什么内容都有,不一定准,实时检索有时候也会引用错误内容,这对 EEAT 来说是不友好的。

想解决这个问题,你就要给它优质信息库,再通过 prompt 或者专门做一个 gpt bot 来严格指导它。

这个工具能够加速你搭建信息库的整个过程,库搭好了,实现 EEAT 就完成了一半。

好处很多,还需要你到手实际体验,那么我们废话不多说,直接进入正题。

工具操作步骤:

1. 复制脚本,并按照如下视频示意操作:

2. 等待 Import Libraries 加载完成,然后来到 File Input,点击 Choose Files 上传带有你 url 的 csv 文件;

3. 脚本会自动生成并下载 PDF 文件;

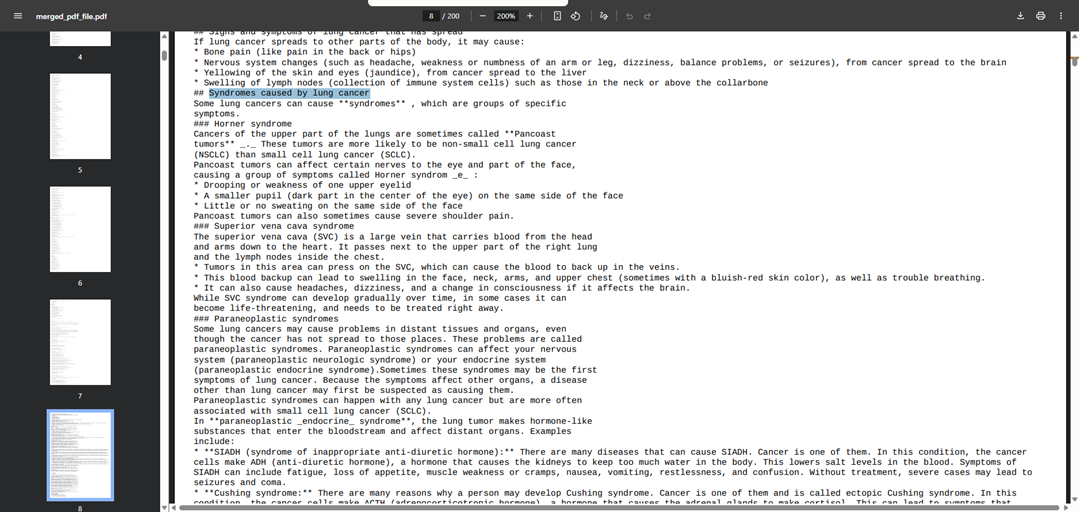

4. PDF 内容效果如下:

5. 步骤结束,很简单。

*6. 在线脚本链接和本地脚本,获取方式见文末;

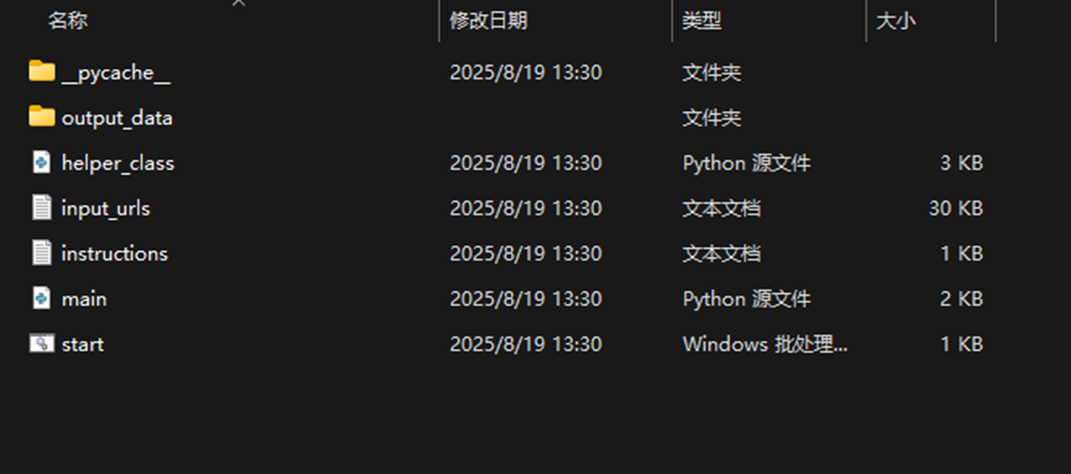

本地脚本

一些提示

很多地方都能用的上这个脚本,比如说:Screaming Frog Crawl、站点地图(sitemap)、Ahrefs top pages、搜索结果页,等等。用途非常广泛,能够为大家节省非常多的时间。

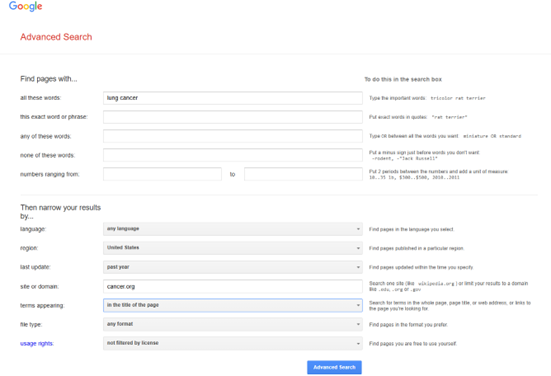

演示上传的文件,是我们使用谷歌高级搜索,从 ACS (American Cancer Society)上快速获取的,关于肺癌的权威文章。

演示文件我们会附在文末,工具大家拿到手可以快速试一试。

注意 GPT 上传文件大小的限制。如果你要抓一整个网站,最终生成的 PDF 文件大小很有可能超出 GPT 的限制,这种情况你就需要使用一些在线工具先将 PDF 拆分才行。

这篇文章要分享的就是这些。

如果你觉得内容对你有帮助,点个赞,帮忙转发给有需要的人。

类似的文章我们固定每周二分享 5-8 篇,如果你不想错过,别忘了置顶本服务号,订阅后右上角省略号即可置顶。

我们下一篇文章再见。

自动化工具获取方式:

服务号对话消息输入关键词“自动化工具”,点击实用资源可以查询其它实用资源。

左下角阅读原文获取演示上传文件的 Google sheet。

文章为作者独立观点,不代表DLZ123立场。如有侵权,请联系我们。( 版权为作者所有,如需转载,请联系作者 )

网站运营至今,离不开小伙伴们的支持。 为了给小伙伴们提供一个互相交流的平台和资源的对接,特地开通了独立站交流群。

群里有不少运营大神,不时会分享一些运营技巧,更有一些资源收藏爱好者不时分享一些优质的学习资料。

现在可以扫码进群,备注【加群】。 ( 群完全免费,不广告不卖课!)

发表评论 取消回复