11月13号,在清迈的 SEO 大会上,Kyle Roof 讲了一个 18 世纪的故事。

1790 年代,一个叫 Wolfgang von Kempelen 的人,在奥地利女皇的生日宴会上看了一场魔术表演。他觉得那个魔术师不过是在装神弄鬼,于是决定第二年带点“真东西”回来。

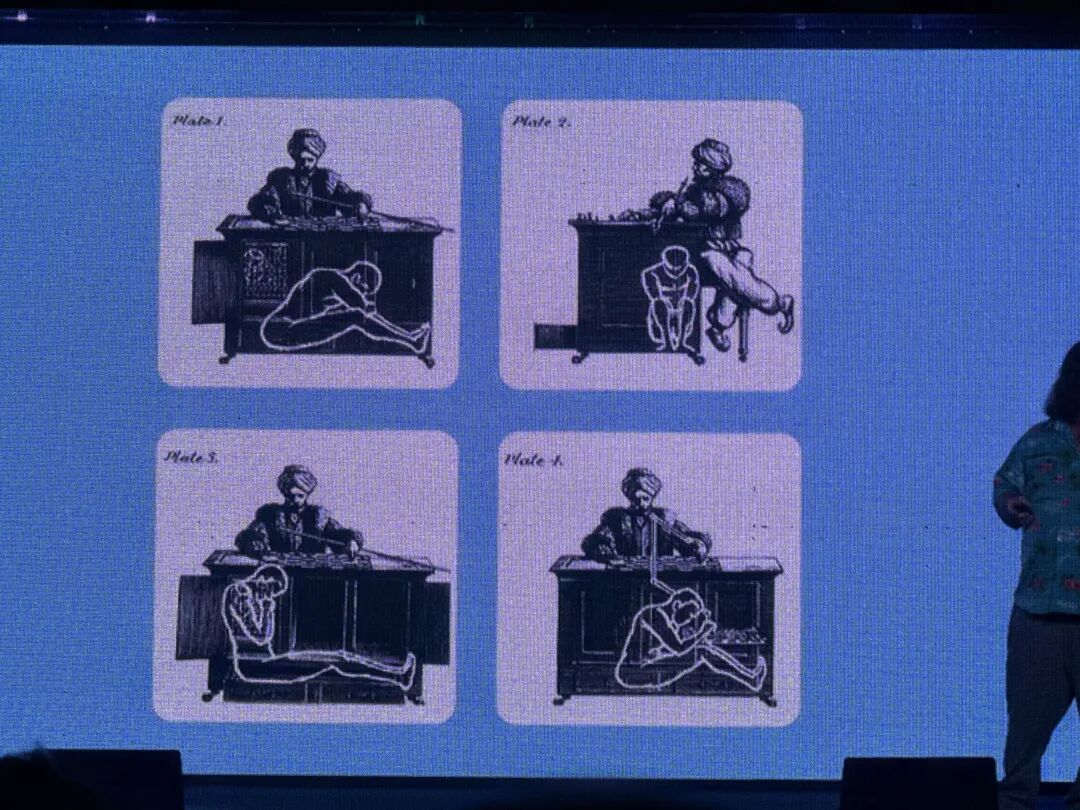

他带来了一台“会下棋的机器人”——后来被称为土耳其行棋傀儡。

表演开始前,Wolfgang 会当众打开机器的柜门,让观众检查里面复杂的齿轮和杠杆结构。确认无误后,他关上柜门,邀请人上台对弈。

机器人赢了。

下一个人上来,又赢了。

再下一个,还是赢。

这台机器随后在欧洲巡演,击败了本杰明·富兰克林,击败了拿破仑。84 年间,只输过五六次。

直到它在一场仓库大火中被烧毁,秘密才被揭开。

机器内部藏着一位真正的象棋大师。柜体里有一个可滑动的座椅,上方是一块磁性棋盘,大师可以看到对手的每一步棋,再通过机械结构操控手臂完成落子。

至少有 20 位象棋大师参与过这场“骗局”,没有一个人说漏过嘴。Kyle 说,他们大概都很享受能和拿破仑下棋这件事。

但真正有意思的,是观众的反应。

人们并不是被骗,而是主动选择相信。

当你看到机器流畅地思考、精准地落子,很容易就会接受一个结论:

——这一定是真正的“智能”。

Kyle 用这个故事开场,并不是为了讲历史。

他想说的是:

今天的 AI 写作工具,本质上和那台机器没有区别。

它看起来在自动运转,但真正决定输赢的,始终是藏在背后的那个人。

一个让他找到定位的测试方法

Kyle 一直强调,他更相信数据,而不是感觉。

2013 年,他想验证一个看似简单的问题:

H1 标签是不是比 H2 更重要?

他去 Google 搜答案,结果是:

有人说是,有人说不是,有人说“视情况而定”。

这对他来说毫无意义。

于是他设计了一套测试方法:

创建一批几乎完全相同的页面,让它们去竞争同一个虚构关键词。在这个可控环境里,每一次只改变一个变量。

比如:

把第三名页面的 H2 改成 H1,其他条件不变。

如果排名上升,说明是正向因素;

下降,就是负向;

不动,就是无效。

后来他发现,还可以反向验证:

如果加上某个元素排名上升,那么去掉它,排名应该下降。

这套方法极大提高了测试效率。

他在一个只有 40 人的小型会议上分享了这套逻辑。讲了五分钟,他意识到一件事:

台下没有任何人在做类似的测试。

他走下台,给合伙人打电话说:

“我知道我们的定位了。”

当时他们只有两个人加一个虚拟助理。但在后续的销售电话里,他们开始这样说:

“你可以问问你正在接触的其他公司:

他们现在在跑什么测试?

如果他们没有在跑测试,那意味着——

他们是在你的网站上测试,在你的网站上学习。”

靠这句话,他们签下了一批原本不属于他们的客户。

后来,这套方法拿到了美国专利。

Kyle 自嘲说,他可能只是给“科学方法”申请了个专利,但谁会去和美国专利局争论呢。

用乱码排到第一名的那次实验

接下来,是 Kyle 最著名的一个案例。

Rhinoplasty Plano,是一场公开的 SEO 竞赛。目标是在 30 天内,把一个全新域名排到“Rhinoplasty Plano”(德州普莱诺隆鼻手术)这个词的第一名。

比赛结束时,Kyle 的网站排在第五。

第一名是 Igor——Kyle 说他是“现场最高的 SEO”,两人后来成了朋友。

但两周后,事情开始变化。

Kyle 的网站先是进入自然搜索前十,然后继续上升,最终拿到了自然搜索第一,甚至一度把地图结果挤掉,直接显示知识面板。

真正让行业震动的原因只有一个:

整个网站的正文,是用 Lorem Ipsum 写的。

也就是设计师常用的那种占位乱码。

Kyle 做的事情并不复杂:

他计算出目标关键词、变体词、语义相关词应该出现的次数和位置,然后把它们“嵌”进这段乱码里。

没有任何真实内容,只有结构和数学。

随后,Search Engine Land 写了一篇报道,点名了这个案例。

六小时后,网站被 Google 下架。

当天凌晨 1:15 到 1:27,Google 又下架了他另外 20 个测试站点,全部标记为“严重垃圾内容”。

Kyle 一开始也慌了。但冷静下来后,他意识到一件事:

如果他说的是胡扯,如果只是运气好,Google 大可以无视。

但他们没有。

他们专门来“处理”这件事。

这反而说明,他触碰到了真正的规则边界。

几年后,当他重新翻阅 Google 的内容政策时,发现“自动生成内容”那一栏里,多了一条规则:

“对读者没有意义,但包含搜索关键词的文本。”

他把页面丢进 Wayback Machine,发现:

这条规则在那次比赛之前并不存在。

某种意义上,Kyle 是少数几个——

被 Google 写过规则的人。

对我来说,这个案例真正的价值,不在于“能不能这么做”,

而在于:搜索引擎到底是如何理解内容的。

AI 内容测试:问题不在“是不是 AI”

今年 3 月,Kyle 做了一组测试。

他让多个主流大语言模型,用同一个 prompt 写一篇 1000 字的罗马旅游文章。然后用 PageOptimizer Pro 进行评分。

结果非常一致:

• POP 评分:没有一个模型超过 80 • 字数:不少模型连 1000 字都写不满 • 阅读难度:全部是大学水平 • 语义词覆盖:严重不足

一篇 1000 字的页面,Google 通常需要 200 个左右的相关术语来准确理解主题。表现最好的模型,也只给了 50 多个。

他又用 Google 的 NLP API 跑了一遍,测试“概念覆盖率”,结果同样不理想。

Kyle 的结论很直接:

Google 根本不需要“检测 AI”。

它只需要用现有算法,就能判断这些内容它“看不懂”。

更有意思的是,当他在 prompt 里加上“要 SEO 优化”四个字,结果反而更差。

字数下降,语义覆盖下降,概念识别率继续下降。

AI 知道什么是 SEO,但它不会真的执行 SEO。

所以,当有人批量生成几百篇文章后流量暴跌,问题往往不在“被识别为 AI”,

而在于:搜索引擎根本无法确认这些页面在讲什么。

SEO 没死,只是更不容偷懒了

关于“SEO 已死”,Kyle 的态度一如既往冷静。

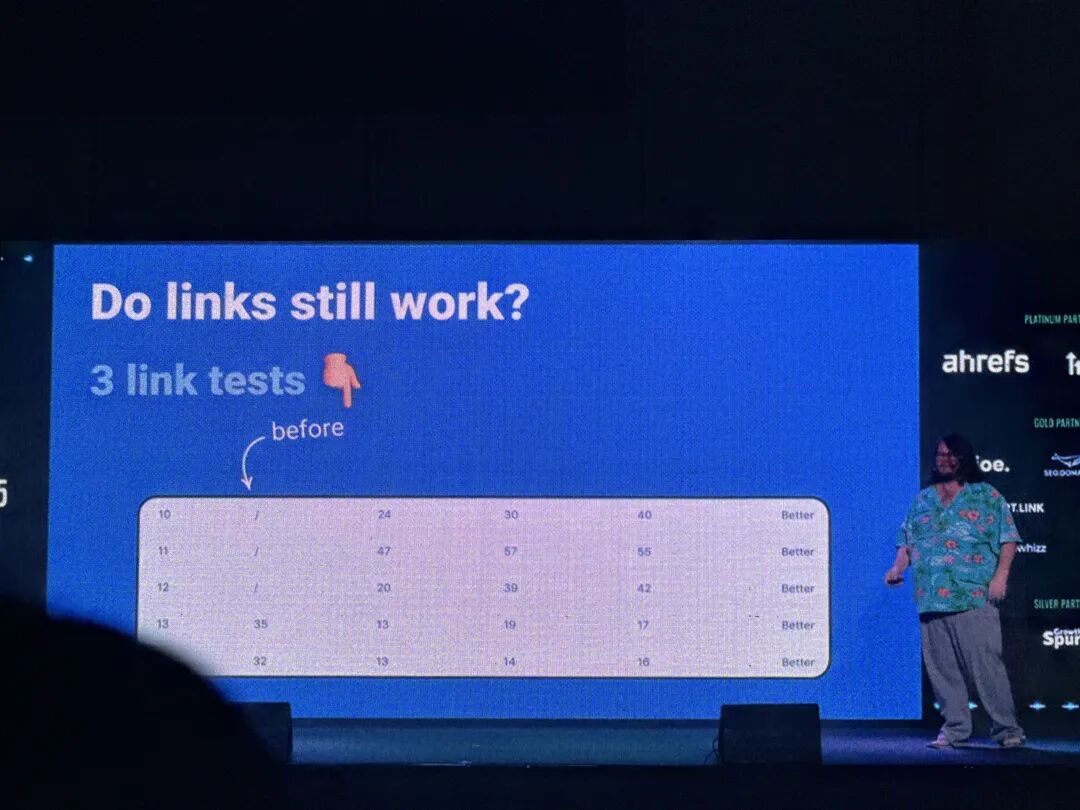

链接有没有用?

有。

在场的另一位 SEO 做了测试:

给排名在 30–40 位的页面加外链,结果全部进入前两页。

算法会调参数,会换权重,但核心逻辑并没有变。

真正变的是:

愿意做长期测试、愿意理解机制的人,越来越少了。

三层筛选 + 内链:不靠外链进入 AI 引用

整场分享里,我认为最值得反复消化的是这一部分。

第一层:Tier Filter

不是“这个词难不难”,而是:

你的网站,配不配这个词。

第二层:KGR

单独用效果一般,但和 Tier 叠加后,非常稳定。

第三层:内链结构

用筛选出的词做支撑页面,只在正文中内链到目标页,不分散权重。

Kyle 展示了两个案例:

都没有依赖 Guest Post,仅靠站内结构,进入了 ChatGPT 的引用来源。

对我来说,这一段不是“方法”,而是一个提醒:

AI 引用,本质上仍然建立在搜索引擎可理解的结构之上。

为什么我要把这场演讲整理出来

不是因为 Kyle Roof 有多大名气。

而是因为他说的每一个判断,我都能用自己的实践去验证。

我做了十年 SEO。

AI 出现之后,行业里充斥着两种声音:

一种是“AI 会取代一切”,

一种是“SEO 已死”。

这两种,我都不信。

我更相信测试,相信数据,相信那些你亲手跑出来、别人可以复现的结果。

这也是我们团队一直在坚持的事:

不追热点,不制造焦虑,把策略跑通了再说。

Kyle 最后那句话我很认同:

AI 只是新的 KPI,不是游戏规则的改变。

规则没变。

变的是,愿意认真研究棋盘的人,越来越少了。

而那些愿意下笨功夫、愿意去找那一步隐藏棋的人——

他们不只是在逃脱。

他们会赢。

文章为作者独立观点,不代表DLZ123立场。如有侵权,请联系我们。( 版权为作者所有,如需转载,请联系作者 )

网站运营至今,离不开小伙伴们的支持。 为了给小伙伴们提供一个互相交流的平台和资源的对接,特地开通了独立站交流群。

群里有不少运营大神,不时会分享一些运营技巧,更有一些资源收藏爱好者不时分享一些优质的学习资料。

现在可以扫码进群,备注【加群】。 ( 群完全免费,不广告不卖课!)

发表评论 取消回复